Début mai 2018, un journaliste travaillant aux États-Unis s’est entretenu avec le responsable de « Google news ». L’interview, publiée sur le site de la fondation pour le journalisme d’Harvard, a été l’occasion d’aborder quelques points sensibles. Entre autres : les « fausses nouvelles », la hiérarchie des contenus proposée par Google et la façon dont le moteur de recherche s’adapte au règlement général de protection des données (RGPD), entré en vigueur le 25 mai dernier. Le bureau de Ganesh vous propose une traduction des questions les plus intéressantes, ainsi qu’une analyse critique des propos de Google.

David Skok (journaliste) : on entend souvent que Google est plutôt conservateur dans sa façon de percevoir la liberté d’expression. Qu’en pensez-vous ?

Richard Gingras (responsable de Google news) : la véritable nature de « Google news » est la diversité des sources et la diversité des points de vue. La question que je pose souvent aux équipes de Google search [les personnes travaillant sur le moteur de recherche – note du bureau de Ganesh] est : quel est notre travail ? Dans beaucoup de cas, il s’agit de livrer des réponses simples aux questions simples que se posent les internautes. Par exemple, donner la taille d’une personnalité, ou l’horaire de la prochaine séance de cinéma. Mais pour beaucoup de questions, il n’y pas de réponse simple.

Dans ce genre de cas, notre philosophie est la suivante : comment donner à nos utilisateurs et utilisatrices les outils et informations dont ils ont besoin pour développer leur esprit critique, en espérant qu’ils et elles parviennent à être mieux informé·es – et faire ce travail de manière apolitique ?

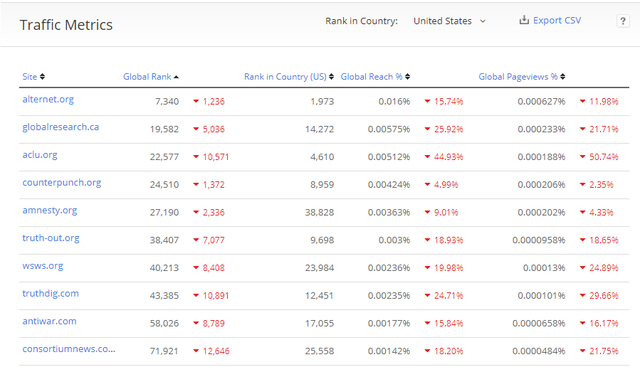

Le point de vue du bureau de Ganesh : malgré ses apparentes bonnes volontés, Google est hypocrite. Le concept de « fausses nouvelles » a émergé, médiatiquement, en 2016 (suite au référendum du Brexit et à l’élection de Donald Trump). Depuis, cette idée est devenue une véritable obsession médiatique et Google, ainsi que Facebook, a été accusé d’avoir favorisé l’élection de Trump. Google a alors annoncé, en 2017, une modification de son algorithme. L’objectif : favoriser les informations rigoureuses. Un objectif noble mais qui a abouti à une restriction du pluralisme : les sites d’informations qui souhaitent apporter un autre regard sur l’actualité ont souvent été déclassés par le moteur de recherche.

Ce déclassement s’est opéré au profit des médias traditionnels. Ceux-ci ont alors encore plus de visibilité qu’auparavant, au détriment des sources alternatives, quelles quelles soient. Un résultat qui contredit frontalement l’objectif proclamé par Google : « comment donner à nos utilisateurs et utilisatrices les outils et informations dont ils ont besoin pour développer leur esprit critique.«

David Skok (journaliste) : YouTube et Google avancent souvent que leurs équipes ont beau mobiliser des paramètres de plus en plus fins dans leurs algorithmes, in fine, ces algorithmes ne présenteront toujours que la face émergée de l’iceberg. Que faites-vous, chez Google, pour vous assurer que des contenus toxiques n’en fassent pas partie ?

Richard Gingras (responsable de Google news) : c’est un problème délicat, avec des effets de bord. Certaines personnes affirment que si je regarde une vidéo extrémiste sur YouTube, je me verrai proposer une autre vidéo extrémiste. Oui, c’est vrai. Nous ne voulons pas que des vidéos extrémistes soient présentes sur notre plateforme et si elles violent nos règles, elles seront bannies. Mais il y a aussi beaucoup de contenus en accord avec nos règles sur YouTube. Et je rappelle que l’algorithme de YouTube qui, en un sens, peut renforcer notre intérêt pour un mauvais sujet, va tout autant renforcer notre intérêt pour les sujets positifs. Par exemple, quelqu’un qui s’intéresse aux sujets des droits humains se verra proposer d’autres vidéos sur ce sujet. L’enjeu est donc le suivant : comment gérer cet équilibre délicat tout en restant conforme à nos règles ?

Un autre problème posé par cet enjeu est la démonétisation [les auteurs et autrices voient la diffusion de publicité interdite sur une ou plusieurs de leurs vidéos, les privant ainsi de revenus – note du bureau de Ganesh] des vidéos perçues comme problématiques, même si elles ont une valeur citoyenne. Par exemple : les droits des personnes trans. Nous faisons donc face à un problème difficile ici et je ne prétends pas que nous l’avons résolu parfaitement. Il y a encore beaucoup de travail.

Le point de vue du bureau de Ganesh : ici, le responsable de « Google news » se prête volontiers au jeu d’une question mal posée. Les « contenus toxiques » sont en effet comme les « fausses nouvelles » : un concept mal défini, voire impossible à définir précisément, à quelques évidentes exceptions près. Nous sommes ici davantage dans un jugement moral qu’une approche scientifique.

Richard Gingras, le responsable de « Google news », a donc beau jeu d’affirmer que les « bulles de filtres » (des boucles algorithmiques qui nous enfermeraient dans nos représentations du monde en nous présentant seulement des contenus correspondant à nos convictions) provoquent aussi des effets positifs (« quelqu’un qui s’intéresse aux sujets des droits humains se verra proposer d’autres vidéos sur ce sujet« ). Cette réponse, sous des airs d’évidence, confirme un concept – les bulles de filtres – pourtant largement questionné par la littérature scientifique.

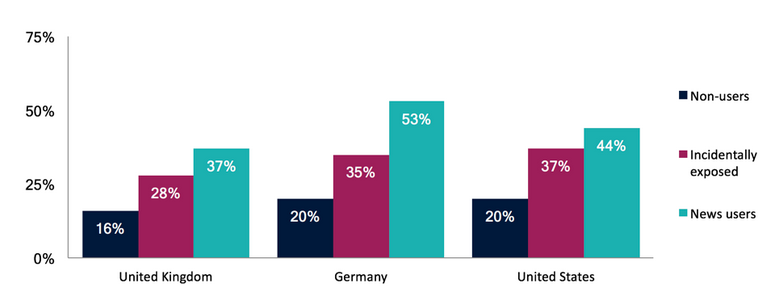

Les réseaux sociaux, par exemple, sont souvent accusés d’être les responsables de ces bulles de filtres en raison de leur tri algorithmique. Une accusation portée contre Google également, on l’a vu. Or, en réalité, les réseaux sociaux ne fabriquent pas de bulles de filtres puisque la majorité des utilisateurs et utilisatrices consultent plus de sources d’information que les internautes qui n’utilisent pas de réseaux sociaux. Mieux : les utilisateurs et utilisatrices consultent des sources politiquement plus diverses que les autres internautes. Cela ne signifie pas que le problème des bulles de filtres n’existe pas, mais simplement que c’est un sujet qui préexistait à l’apparition des réseaux sociaux et que ceux-ci n’ont, d’après les recherches réalisées par la fondation pour le journalisme d’Harvard, pas renforcé ce biais, au contraire.

David Skok (journaliste) : Le 25 mai dernier est entré en vigueur le règlement général sur la protection des données (RGPD) européen. Ce règlement oblige les sociétés qui possèdent et exploitent des données personnelles, à respecter de nouvelles règles plus protectrices de la vie privée des internautes. Récemment, quatre groupes de presse ont accusé Google de protéger son modèle économique plutôt que de véritablement respecter le RGPD, ce qui saperait leurs efforts pour respecter l’esprit du RGPD. Que répondez-vous ?

Richard Gingras (responsable de Google news) : le règlement affirme la chose suivante : si une entreprise souhaite construire une base de données client·es à des fins commerciales, elle a besoin d’avoir l’accord explicite de chaque internaute. Ce que Google a dit est : oui, nous allons le faire. Pour ce qui nous concerne, c’est aux éditeurs de presse d’obtenir cet accord explicite car sont leurs lecteurs et lectrices, pas les nôtres. (…)

Si vous utilisez nos services de distribution et ciblage de publicité sur vos sites internet, vous devez avoir la permission de vos lecteurs et lectrices. On ne peut pas, au sein de Google, demander cet accord à votre place. C’est aux groupes de presse de faire ce travail.

Le point de vue du bureau de Ganesh : l’application du RGPD et le conflit qui s’ensuit entre journaux et Google illustre une nouvelle fois la dépendance des éditeurs de presse à Google. Une dépendance qui n’est pas sans avoir déjà posé problème, par exemple quand les médias espagnols avaient attaqué Google en l’accusant de pillage de propriété intellectuelle. En retour, l’entreprise californienne avait arrêté son service « Google news« dans le pays. Le trafic des journaux locaux s’était alors effondré.

Google est incontestablement une des principales portes d’entrée du web, pour le meilleur et pour le pire. Ici, le pire se manifeste. Tous les éditeurs de contenus sont concernés, même si le cas abordé ici concerne seulement la presse. De la même manière qu’une trop grande dépendance à Facebook engendre des problèmes maintenant bien compris, une dépendance à Google provoque les mêmes effets. La réponse à cet enjeu est loin d’être simple, mais des alternatives existent.

Si vous avez des questions, vous pouvez nous les poser ici ou sur notre page LinkedIn. Nous sommes au moins aussi aimables qu’un représentant de Google 🙂

Vous pouvez aussi recevoir tous nos conseils pratiques dans votre boîte mail une fois par mois !